달마다 한번씩은 들어오려고 했는데 연간이 되는 거 같아 멋쩍네요. 소식이라고 해봐야 늦은 거긴 하지만 엔비디아 이야기입니다.

ㄷㄱ님 땜빵으로 엔비디아 미디어 브리핑 행사에 다녀왔었는데, 거기서 들은 프레젠테이션과 개인적으로 찾아보면서 하드웨어와 게임의 미래에 대해 생각해봤습니다. 자세한 행사 참여 후기는 옆동네의 이 글(링크)를 참조하세요.

엔비디아의 RTX시리즈가 GTX와 근본적으로 다른 두 가지는 첫째, 어플리케이션 지정 집적회로 (Applicaction Specific Integrated Cirguit; ASIC)를 2종 (RT 코어, 텐서 코어)를 사용했단 것과 둘째, 셰이더 구조를 좀 더 유연성 있게 개편했단 것이 있습니다. 만약 그간 해오던 대로 양적 성장을 했다면 그냥 GTX로 갔겠죠. 여기에 대해 간단히 설명하겠습니다.

I. ASIC과 퍼포먼스

1. 레이 트레이싱?

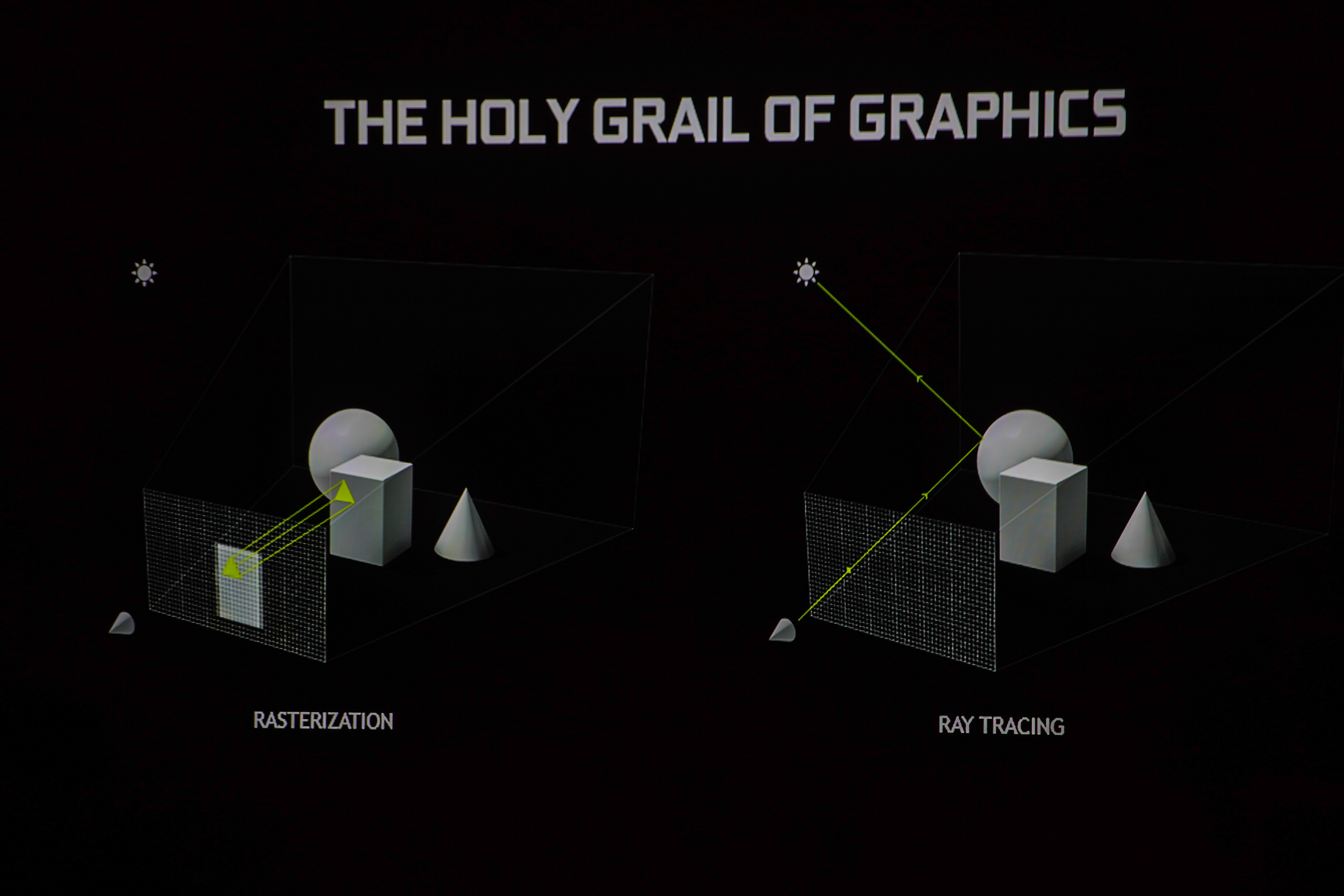

RTX라고 이름을 바꾼 마당에 레이 트레이싱이 당연히 주요한 화두죠. 자세한 원리야 널리 알려진대로 빛의 경로를 역추적하는 것입니다. 그러나 이렇게 말하면 좀 덜 와닿죠. 레이 트레이싱과 현재 광원 효과와의 근본적인 차이는 뭐냐고 묻는다면, 실제 광원에서 나온 빛을 반사/굴절시켜 화면 전체에 뿌려준다는 것입니다. 쉽게 말하면 지금까지의 광원 효과는 한 방향의 인공 조명을 곳곳에 두고 빛을 쏴서 태양의 반사 효과를 흉내 낸 것이고, RTX는 실제로 벽지, 반사 표면, 거울, 유리 등등에 의해 발생하는 태양빛의 경로 변화 효과를 실제로 묘사한 것입니다. 물론 현재 짝퉁(?) 조명 효과 또한 상당한 수준이고, 굳이 레이 트레이싱 같이 비싼 대가를 치러야 하는 지는 생각해 볼 문제입니다만 최소한 물리적으로 정확한 빛을 표현하는 방향인 것은 사실입니다.

위의 메트로 엑소더스의 데모 영상 또한 태양광 단 하나의 광원으로 부터 나온 빛을 반사, 굴절 시켜 전역 조명을 만들어낸 것입니다.

다만 RTX 기술은 우리가 보는 3D애니메이션 같은 실제 영상 업계에 쓰이는 것보다 훨씬 꼼수가 많이 들어갔고, 종래의 그래픽 표현 방법(래스터라이제이션)과 혼용해서 쓰이기 때문에 화면에 그려지는 모든 부분을 레이 트레이싱으로 구현한 것은 아닙니다. (링크 참조) 오히려 래스터라이제이션이 주가 되고, 부가적으로 레이트레이싱 향을 첨가한 정도로 생각하시는 게 더 맞을 거 같습니다.

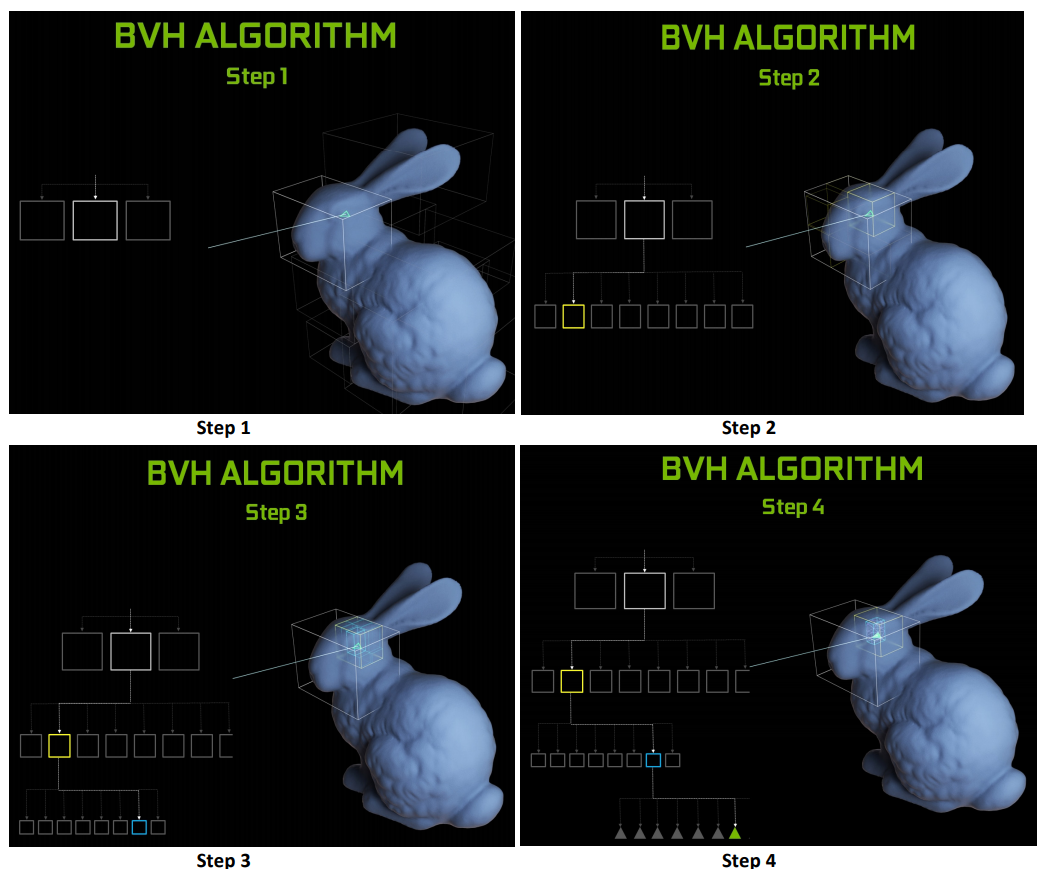

RTX 카드의 RT코어 작동 원리는 쉽게 설명드리면 다음과 같습니다. 1. 레이 캐스팅 작업을 셰이더로부터 RT코어로 따온다. 2. 전체 도형들을 큰 덩어리로 분류하고, 거기에 빛의 경로가 있는지 찾는다. 3. 빛의 경로가 있는 큰 덩어리 안을 다시 작은 덩어리로 분류하고 그 안에 빛의 경로가 있는지 찾는다. 4. 대상이 되는 도형에 빛이 닿을 때 까지 반복한다. 5.추적 결과를 셰이더로 돌려준다. 이러한 과정의 효율성은 깡 셰이더만을 쓸 때에 최대 10배에 해당합니다. 전용 하드웨어를 쓰는 효과죠.

2. 텐서 코어?

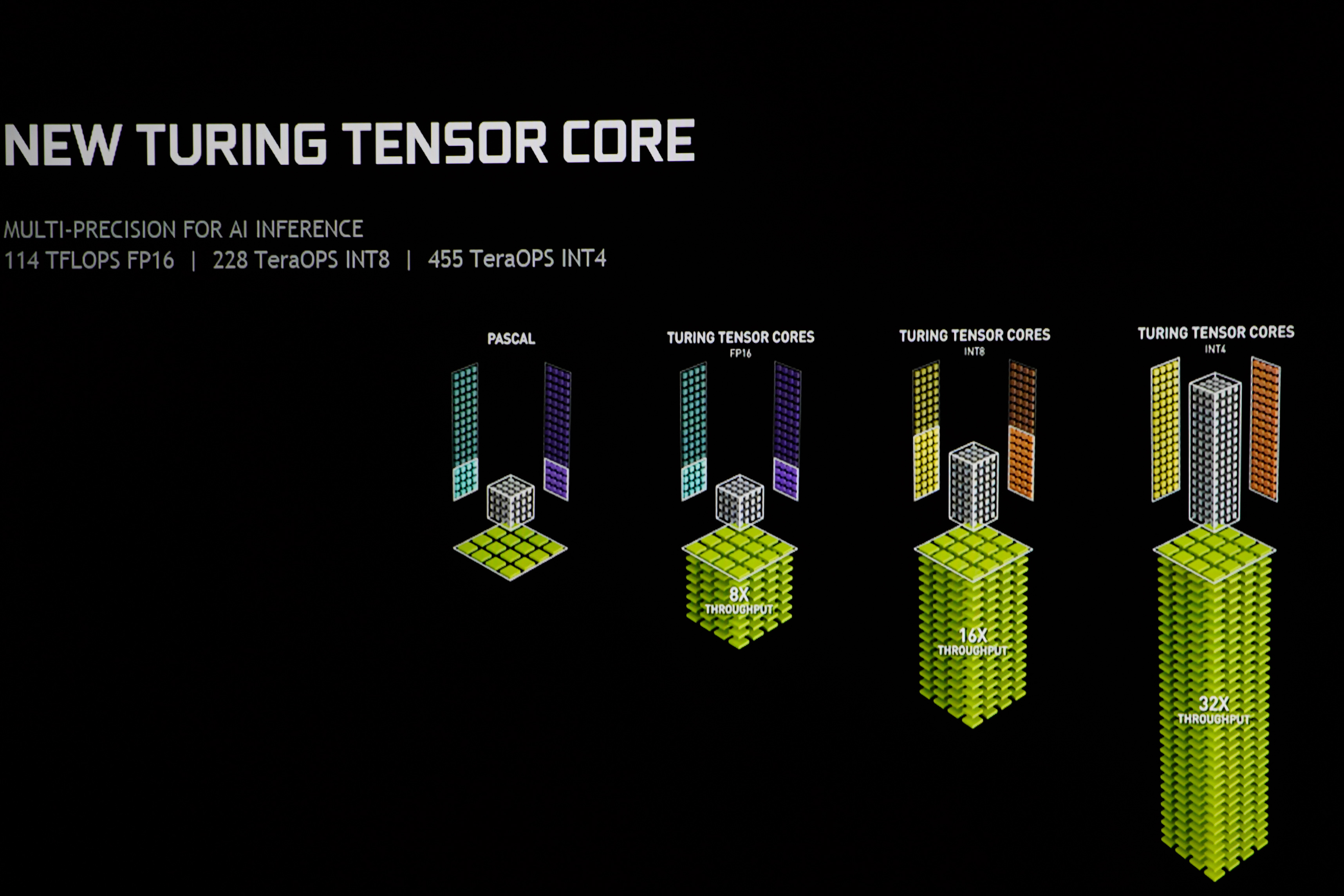

텐서 코어는 흔히 우리가 아는 알파고에서도 쓰였던 구글의 TPU의 그것과 같습니다. 4*4 행렬의 합연산과 곱연산을 한번에 수행하는 걸로, 딥 러닝의 핵심인 "추론" 과정에 최적화 되어 있는 ASIC입니다. 추론 과정은 가능성의 가지를 찾기 위해서 정밀하진 않더라도 연산 총량(스루풋)이 많은 연산 방식이 더 유효한 관계로 스루풋을 많이 뽑아내는 텐서 코어가 유리합니다. 8비트 정수, 4비트 정수 등의 연산에서는 사이클(클럭)당 최대 16배 내지 32배의 스루풋을 뽑아낼 수 있습니다.

다만 이러한 높은 스루풋의 대가로 텐서 코어는 저 행렬 연산 외의 범용 연산은 전혀 못하기 때문에 게임 업계에서는 그냥 시체나 다름없었습니다. 그래서 엔비디아에서는 가장 가능성이 높은, 즉 그럴듯한 결과를 찾아내는 딥러닝의 특성을 이용해 보간법(Interpolation)을 게임에 도입하려고 합니다. 구체적으로는 고화소화 (AI Super-rez), 프레임 보간, DLSS등을 꼽을 수 있습니다. 엔비디아 측에서는 DLSS에 역점을 두고 있습니다. DLSS는 딥러닝 수퍼 샘플링으로, 안티에일리어싱의 일종입니다. 고해상도 이미지를 엔비디아 데이터 센터에서 "훈련"(훈련과 추론은 링크 참조) 시켜 놓으면 게임 엔진으로 피드백하고 사용자 하드웨어는 이를 다시 "추론" 해서 최상의 안티에일리어싱 결과를 뽑아내는 것이라고 합니다. 레이 트레이싱에서도 텐서 코어가 쓰일 수 있는데, 아무래도 연산이 부족해 광선이 모자라 노이즈가 낀 이미지를 보간해서 복원하는 것입니다.

3. 두뇌 풀 가동

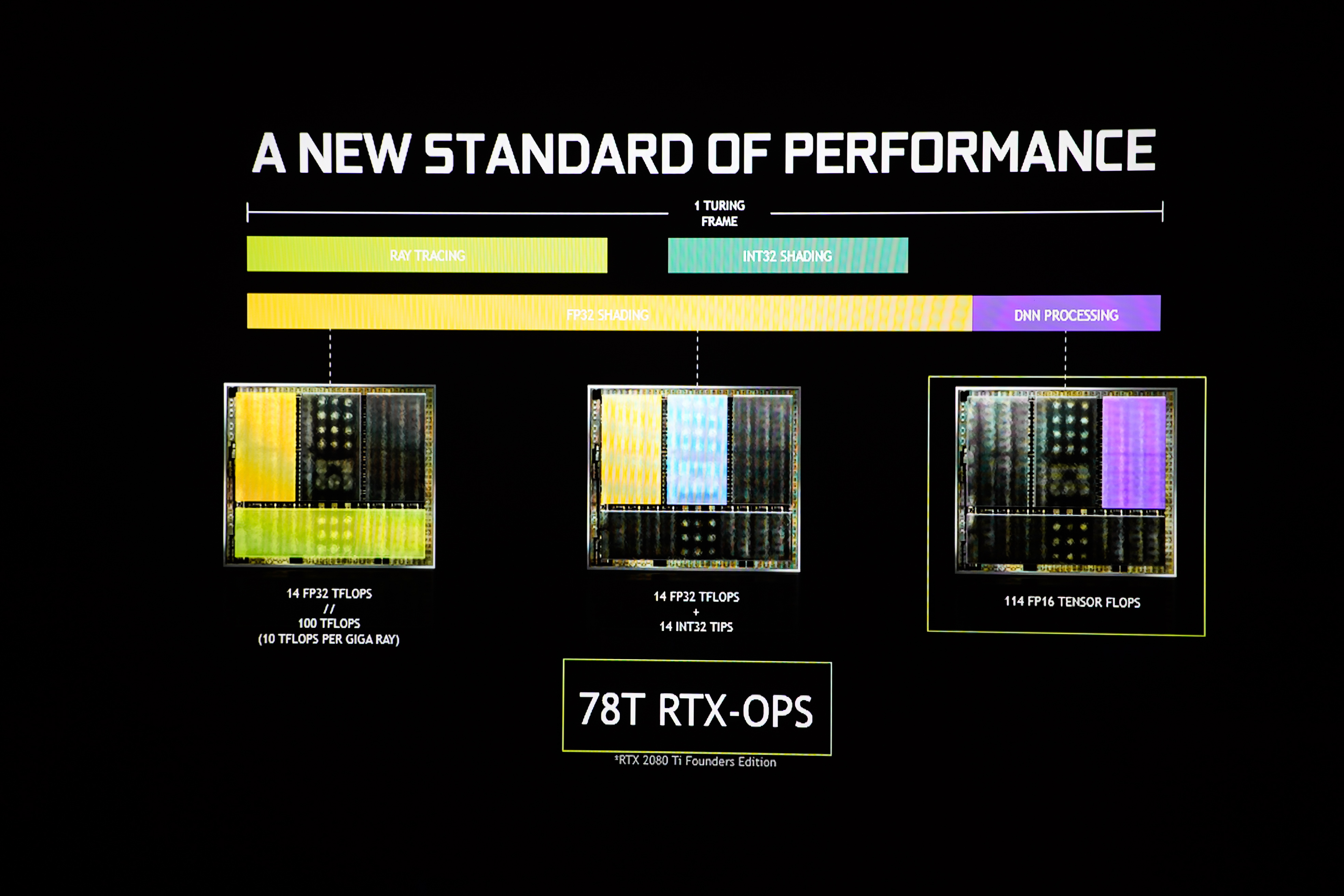

RTX 시리즈의 가장 큰 특징읜 위의 1. RT 코어와 2. 텐서 코어, 그리고 종래의 셰이더 코어를 셋 다 동시에 활용하여 프레임을 생성해낼 수 있습니다. 레이 트레이싱을 하는 경우 셰이더가 전체적인 3D 오브젝트를 그리고, RT코어가 빛을 쏘면 모자란 빛은 텐서 코어로 땜빵하는 구조입니다. 그런 관계로 각각 코어에 가중치를 고려하여 총합 퍼포먼스를 계산해낸 것이 RTX 옵스입니다.

물론, RT코어와 텐서 코어는 레이 트레이싱이나 딥러닝을 쓰지 않으면 그냥 전기만 축내는 잉여 회로입니다. 그런 관계로 레이 트레이싱이 적용되지 않는 게임에서는 ASIC의 효과를 전혀 보지 못합니다. 튜링은 다만 전통적인 연산 유닛도 조금 손봤기에 아주 파스칼 재탕은 아닙니다.

II. 셰이더 개편

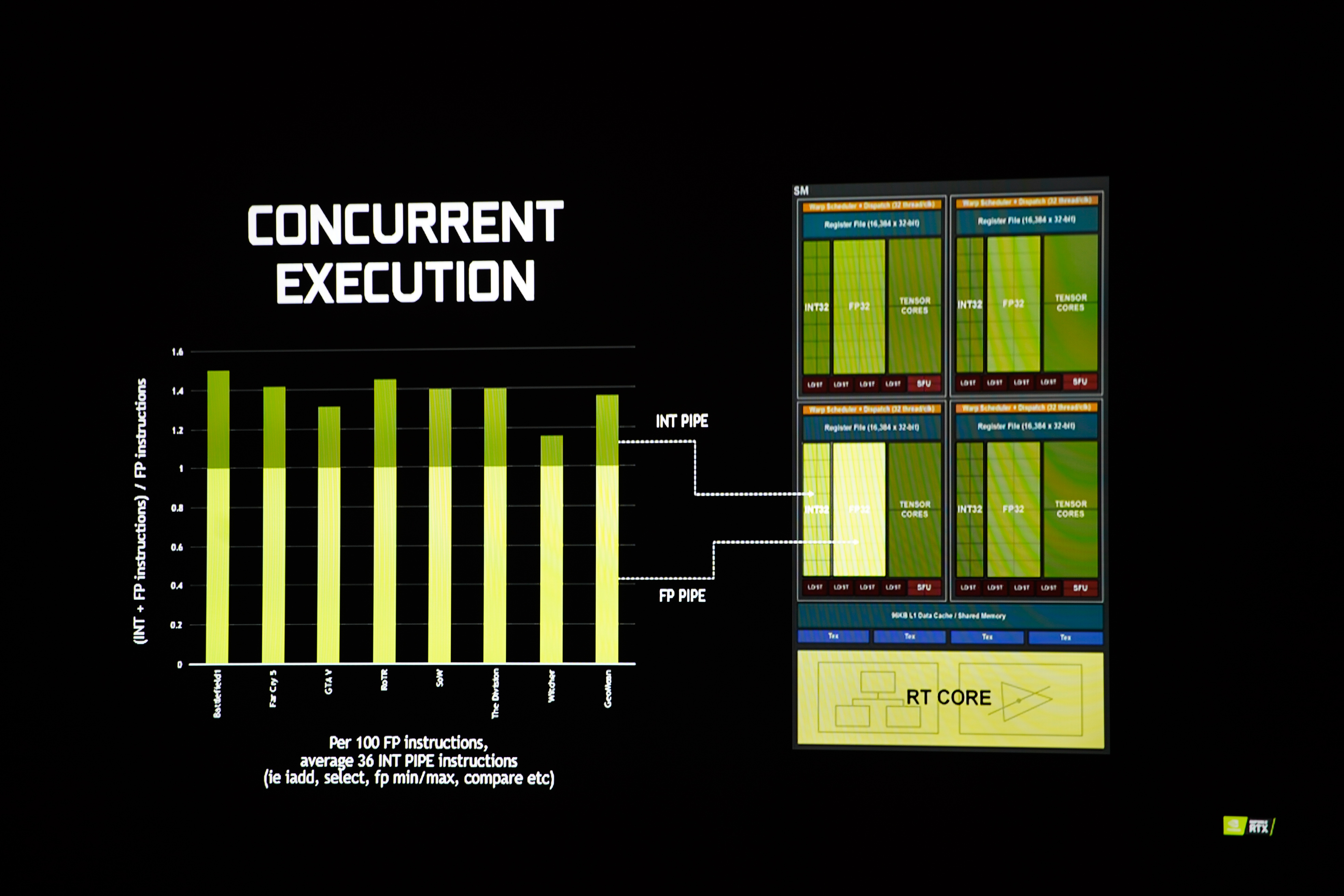

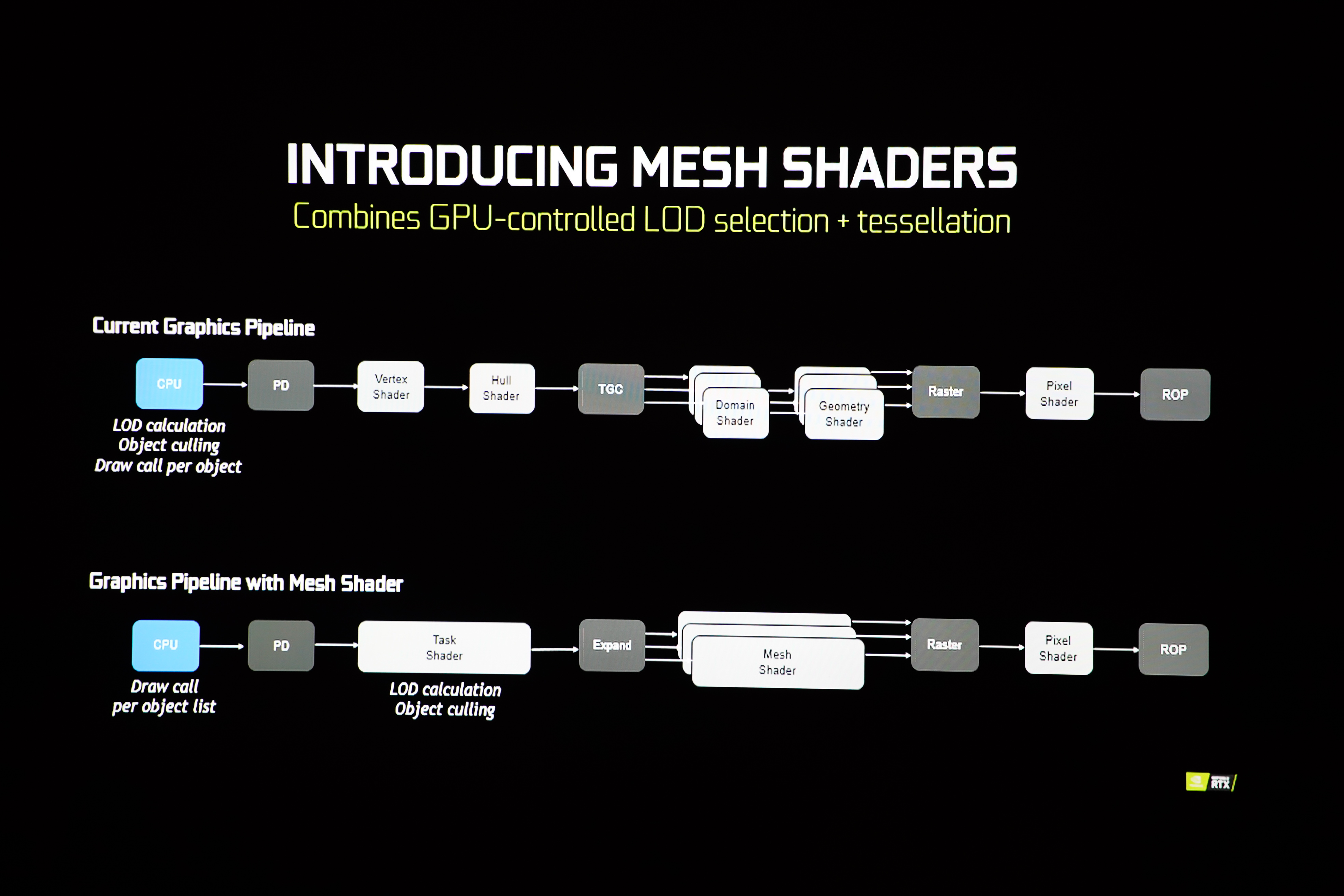

하드웨어 덕후라면 관심을 가지실 수 있어 간단히만 설명 드리면 셰이더도 두 가지가 크게 바뀌었습니다. 정수 유닛과 부동소수점 유닛을 분리하여 동시에 정수 연산과 부동소수점 연산을 처리할 수 있고, 그래픽 셰이더 파이프라인을 메시 셰이더로 통합하고 태스크 셰이더를 두어 동적 디테일 수준 처리가 가능해져서 연산의 유연성을 확보하고, 연산 총량을 줄일 수 있게 되었습니다.... 한국어로 하면, 전자는 연산 성능 증가, 후자는 연산 최적화입니다. 후자는 지원하지 않는 게임에서 효과를 보긴 어렵고, 전자는 모든 게임에서 효과를 볼 수 있을텐데, 대략 1.3배 정도의 스루풋 증가 효과라고 합니다.

III. 성능/가격

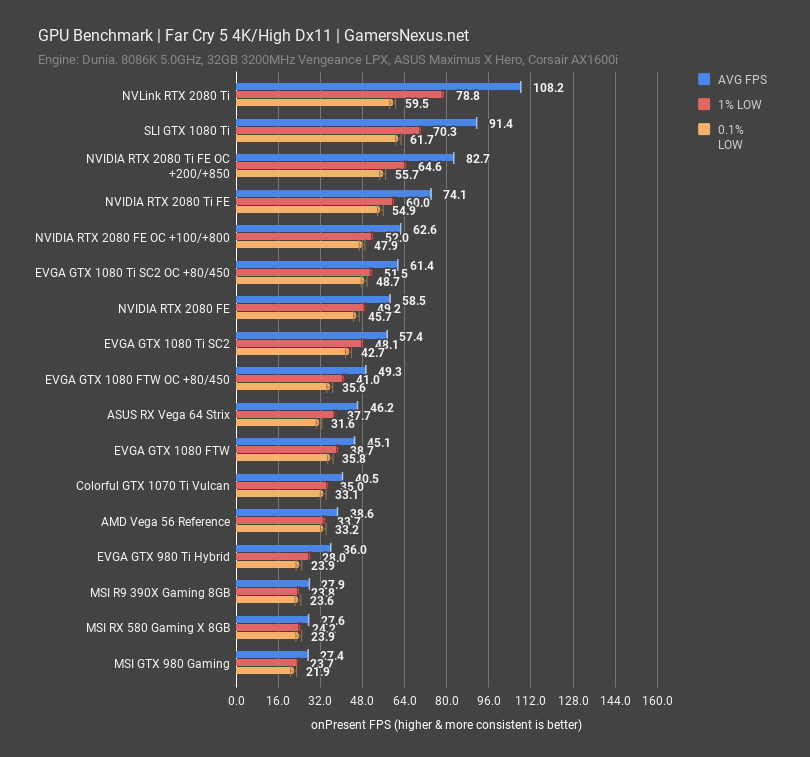

클래식한 파 크라이 5에서도 당연히 RTX 시리즈가 왕위를 찬탈했습니다. 단일 카드로 4K를 정복한 건 사실 파스칼 때 부터이긴 합니다만 이번에는 그 지위를 공고히 했고, 21:9 3440*1440 100Hz 게이밍 모니터를 타겟으로 삼을 수도 있게 되었습니다. 동위 그래픽카드 대비 대략 1.3배의 퍼포먼스 향상입니다. 아쉬운 점이라면 맥스웰에서 파스칼로 넘어갈 때는 1.6배의 퍼포먼스 향상이 있었고 가격 상승은 억제되어 실질적인 가성비는 크게 좋아졌습니다. 그러나 파스칼에서 튜링으로 넘어갈 때에는 오히려 가격이 크게 상승한 데 비해 일반적인 성능은 크게 증가하지 않아 실질적인 가성비는 떨어진 셈입니다.

| 코어 | 다이 크기 | 가격 | |

| RTX 2080Ti | TU102 | 754mm2 | $999 |

| GTX 1080Ti | GP102 | 471mm2 | $699 |

| RTX 2080 | TU104 | 545mm2 | $699 |

| GTX 1080 | GP104 | 314mm2 | $549 |

| RTX 1070 | TU106 | 445mm2 | $499 |

| GTX 1070Ti | GP104 | 314mm2 | $449 |

그러나 과연 창10한가에 대해서는 글쎄요라고 대답하고 싶습니다. 이 업계에서 가장 중요한 것은 실리콘의 크기입니다. 우리가 아는 반도체는 원판에 빛으로 새겨넣은 것으로, 칩 하나의 크기가 커질수록 불량률은 급수적으로 늘어날 뿐만 아니라 원판 특성상 온전한 형태로 뽑아낼 수 있는 면적 비율도 점점 줄어듭니다. 과연 이게 소비자용인가 싶을 정도로 다이가 큰 관계로 이정도 돈을 받는 것은 예상할 수 있는 범위라고 생각합니다.

IV. 엔비디아는 왜

솔직히 엔비디아 입장에서도 저정도 다이 크기로 칩을 생산할 수 있었으면 전통적인 성능 향상을 생각할 수 있었을 겁니다. 당장에 차상위 카드인 RTX 2080만 하더라도 ASIC빼고 거기에 하던 대로 셰이더와 ROP를 때려박으면 GTX 2080Ti 게임 성능을 넘어서는 것도 가능할 것입니다. 다만 문제는 미래는 그렇게 호락호락하지 않다는 것입니다. 반도체 소식을 들어보면 EUV등 여러가지 이유로 공정미세화가 점점 까다로워지고, 종국에는 미세화로 얻어지는 가성비 이득이 없어지게 될 것임은 분명합니다. 또한 하드웨어 수준이 따라가지 못하면 게임 그래픽의 향상 또한 무의미하게 될 것입니다. 따라서 엔비디아는 게임 업계에 방향 전환을 요구하고 있는 셈입니다. "이제는 전통적인 개발 방식으론 한계가 곧 찾아 올테니 새로운 길을 찾으라, 그리고 우리는 이 길을 가겠다." 죠.

당장에 시연에서도 실제 게임 보다는 자사의 데모를 보여주면서 시연하는 이유도 게임 업계는 미적지근한 데 비해 엔비디아가 더 적극적으로 어필해야 하기 때문인 듯 합니다. 다만 레이 트레이싱이나 딥 러닝을 게임에 도입하는 것은 필연적으로 기술력을 필요로 하고, 이는 전문 인력 비용으로 연결되니 게임 제작사 입장에서도 부담인 것은 당연합니다. 다만 게이머의 눈은 높아져 가는 데 비해 레이 트레이싱을 제외하면 렌더링의 돌파구는 별로 없는 관계로 어쨌든 좋든 싫든 엔비디아의 방향으로 가야하긴 합니다.

이러한 기술을 넣기에는 조금 이른 게 아닌가 하는 것도 사실입니다. 최상위 TU102에만 이러한 ASIC을 넣을 수도 있지만 좀 더 넓은 계층의 게이머로 하여금 레이 트레이싱을 써보라는 의미에서 TU106, 즉 3순위 하드웨어까지도 RT코어와 텐서 코어를 넣은 것이라 생각할 수 있습니다. 결과적으로 하드웨어 보급이 선행되어야 하냐 기술이 먼저 나와야 하냐는 질문은 닭이냐 달걀이냐의 문제와도 비슷하리라 생각합니다.

V. 게임의 미래

게임의 미래, 미래의 게임을 예측하는 것은 결코 쉬운 일이 아닙니다. 다만, 근 10년간의 게임 발전사를 돌이켜 생각해보면 VR빼고 딱히 혁명적이라 부를만한 게 없었습니다. 개중에 개인적으로 가장 인상 깊은 변화는 빛과 그림자를 통해 만들어 내는 조명 효과였습니다. 그 부분에서 레이 트레이싱은 분명 근본적인 혁신임은 부정하기 어렵습니다. CPU 부문은 분명 지난해, 올해에 큰 성장이 있었고 콘솔도 0.5 세대 하드웨어가 발매될 정도로 전반적인 하드웨어 수준은 올라가고는 있습니다. 다만 그래픽적인 분야의 성과가 게임성으로 직결되는 것은 분명히 아닐 것입니다.

오히려 주목해야 할 것은 딥러닝의 성장으로 인해 정교해지는 AI의 도입이 아닐까 합니다. 우리가 생각하지 못하는 방식으로 게임의 세계가 정교해질 수 있다면 근본적인 게임의 혁신이 가능하지 않을까 합니다. 물론, 자본주의 논리가 지배하는 시장에서 게임사가 그래픽 외에 새로운 것을 얼마나 보여줄 수 있을지는 잘 모르겠습니다.

긴 글 읽어주셔서 감사합니다. 질문은 언제든 환영입니다.