미크로틱 국내 시판 주요제품 성능 벤치마크

최근 몇 년간 IT 인프라 전반에서 보이는 움직임은 ‘가상화’와 ‘클라우드 컴퓨팅’으로 대변된다. 지금까지 독립적으로 구성되어 있던 인프라를 모두 풀어헤쳐 유연하게 공유할 수 있도록 재구성하는 이 움직임은 이제 완전히 ‘3세대 IT 인프라 형태’로 자리잡았다.

이렇게 개별 시스템들을 공유 형태로 묶는 데 있어 중요한 요소 중 하나가 바로 네트워크다. 인프라가 보여주는 모습이 단순해지는데 비해서 네트워크 연결은 더욱 복잡해지고 있다.

이제 네트워크는 더 이상 서버와 외부 세계를 연결하는 역할만을 하지 않는다. 서버와 서버 간의 자원 공유를 통한 연결도 IP 기반 네트워크를 사용하고, 서버와 스토리지 간 연결도 비용 효율을 위해 IP 기반 네트워크를 사용하는 경우가 많아지고 있다. 또한 아예 하이브리드 클라우드 등 외부 자원과의 연계에서도 가장 보편적인 IP 기반 네트워크를 사용하게 된다. 덕분에 이제 기업에서 요구하는 네트워크 성능의 기대치는 이전보다 크게 높아졌다.

네트워크가 복잡해지면서 이를 연결하는 스위치, 라우터들의 기능과 성능에 대한 요구도 더욱 커지고 있다. 하지만 대다수의 네트워크 장비들은 성능 수치에 대해 이론적인 최대 수치 혹은 단순한 구성에서의 테스트 결과만을 제시한다. 이와 관련해, 본 리포트에서는 한국에서도 인지도를 높여가고 있는 미크로틱(Mikrotik) 브랜드 주요 장비에 관한 자체 벤치마크 테스트 결과를 정리하였다. 여기에서는 다수의 필터와 방화벽 등이 적용되어, 실제 사용 환경에 가까운 실제 성능을 보여준다는 의미가 있다.

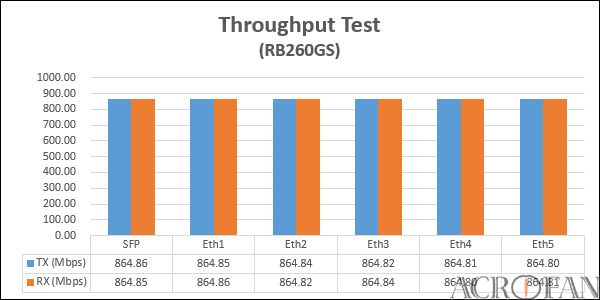

▲ 미크로틱 RB260GS 스위치 테스트 결과, 높을수록 좋다.

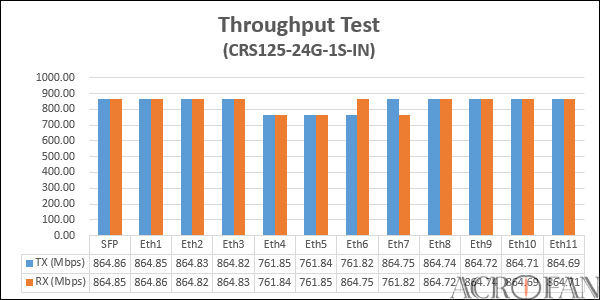

▲ 미크로틱 CRS125-24G-1S-IN 스위치 테스트 결과, 높을수록 좋다.

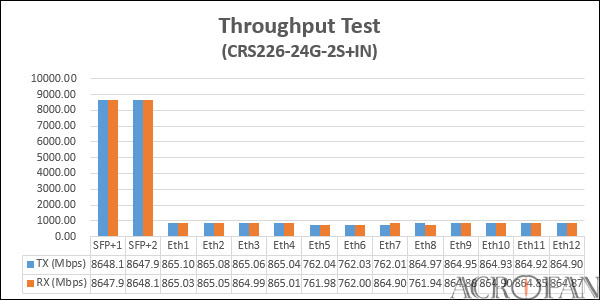

▲ 미크로틱 CRS226-24G-2S+IN 스위치 테스트 결과, 높을수록 좋다.

미크로틱의 스위치 제품군 테스트에는 Optixia XM2 장비와 Ixia IxExplore 애플리케이션이 이용되었으며, 패킷당 64byte, 로드 모듈에서 각 인터페이스를 페어 연결해 900초간 트래픽을 발생시켰다. 테스트 결과가 공개된 모델은 5포트 기가비트 이더넷과 SFP 포트를 가진 RB260GS, 24개 기가비트 이더넷과 1개 1Gbps SFP 포트를 가진 CRS125-24G-1S-IN, 24개 기가비트 포트와 2개의 10G SFP+를 가진 CRS226-24G-2S+IN 이다.

엔트리급 모델인 RB260GS에서 모든 가용 가능한 포트에 부하를 걸었을 때, 6개 포트 모두 고르게 864.8Mbps 정도의 성능을 확인할 수 있었다. 매니지드 스위치의 운영에서 생각할 수 있는 최대 부하를 걸었음에도 모든 포트가 제 성능을 제대로 내고 있으며, SFP 포트와 일반 이더넷 포트와의 연결에서도 성능 차이가 없다. 이는 다양한 연결 구성에서도 균일한, 예측 가능한 연결을 제공할 수 있다는 장점이 있다.

기가비트 24포트급 모델인 CRS125-24G-1S-IN은 테스트 툴의 로드 모듈 수 제한으로 12포트만 테스트되었다. 이 테스트 결과에서 볼 수 있는 재미있는 점은, 12포트 중 세 개 포트 정도가 다소 성능이 떨어지는 것으로 측정되었다는 것이다. 8개 포트는 송수신 모두 864.8Mbps 정도로 측정되었으며, 두 개 포트는 송수신 모두 761.8Mbps, 나머지 두 개는 송신이나 수신 중 하나가 864.8Mbps, 나머지 하나는 761.8Mbps로 나타났다. 이는 내부 구성에서의 특성으로 보인다.

10G SFP+ 포트를 지원하는 CRS226-24G-2S+IN 에서 두 개의 10G SFP+ 포트는 8648Mbps 정도의 성능을 나타냈다. 또한 이 모델에서도 테스트에 사용된 12개의 기가비트 포트 중 3개는 762Mbps 정도의 성능을, 나머지 9개는 865Mbps 정도의 성능을 나타냈다. 일부 포트에서 최대 대역폭이 다소 떨어지게 나오는 것은 내부 구성에서의 버스 공유 등이 원인으로 보인다. 그리고 양 스위치 모두 기가비트 5~8번 포트가 이러한 영향을 받는 것으로 나타났다.

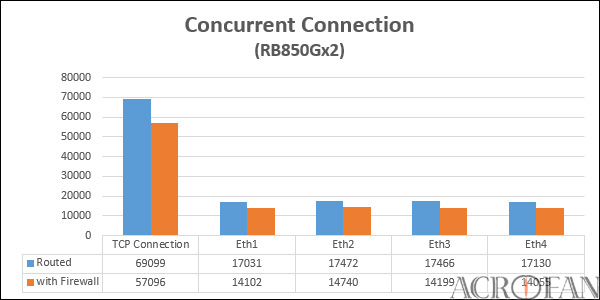

▲ RB850Gx2 Concurrent Connection, 높을수록 좋다.

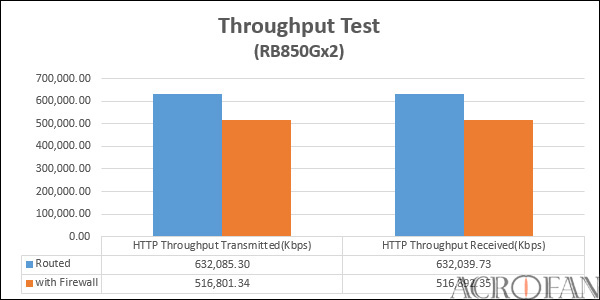

▲ RB850Gx2 Throughput Test, 높을수록 좋다.

라우터는 RB850Gx2, CCR 시리즈 3종 등 총 4종의 테스트 결과가 공개되었다. 장비는 Optixia XM2와 Ixia IxLoad 애플리케이션의 조합이며, 10Gbps 4포트 지원의 NGY-NP4, 1Gbps 12포트 지원의 XMV12 모듈이 사용되었다. 테스트는 L4 처리량과 커넥션을 측정했으며, 일반 라우트 상황과 100개 룰이 정의된 방화벽 규칙 적용으로 상황이 나누어진다. http 1.1 1MB html 파일을 이용해 로드 모듈에서 인터페이스를 연결, 16비트 서브넷을 부여하고 각 호스트는 가능 트랜잭션을 최대한 이용하도록 했다.

PPC 듀얼코어 프로세서를 이용하는 RB850Gx2는 기가비트 5포트를 아데로스 8327 스위치 칩으로 구성한다. 900초 간 진행된 접속수 테스트에서, RB850Gx2는 단순 라우트에서는 총 69,099 커넥션을, 방화벽 적용된 경우에는 57,096 커넥션을 기록했으며, 양쪽 상황 모두 연결 추이의 기울기가 일정하게 유지되었던 만큼 향후 더 올라갈 수 있는 여지가 있는 것으로 나타났다. 테스트 도중의 장비 부하는 단순 라우트에서 39%, 방화벽이 적용된 경우에는 99%에 육박했다.

RB850Gx2의 처리량 테스트에서는 단순 라우트 모드에서 약 632,000Kbps 정도의 처리량을 기록했으며, 단순 라우트 상태에서 장비의 프로세서 사용률은 49% 정도를 기록했다. 방화벽 규칙을 적용하는 경우에는 이보다 성능이 다소 내려가 516,800Kbps 정도의 처리량을 기록함을 확인할 수 있으며, 프로세서 부하는 100%를 기록했다. 또한 방화벽 적용시에는 특정 시점 이후 커넥션 시간이 늘어나고 마지막 바이트 전송 시간은 50~100초간 피크를 찍고 내려오는 특징을 보인다.

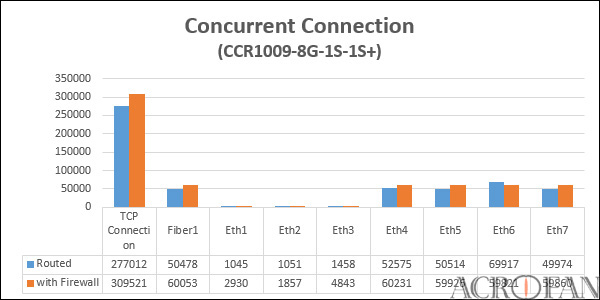

▲ CCR1009-8G-1S-1S+ Concurrent Connection, 높을수록 좋다.

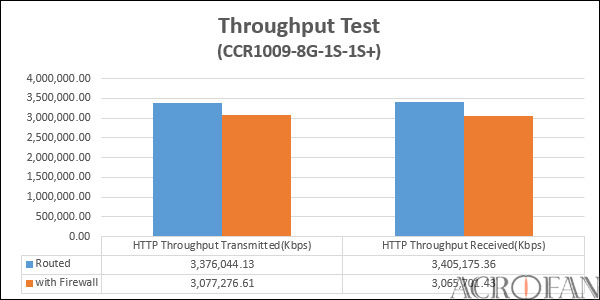

▲ CCR1009-8G-1S-1S+ Throughput Test, 높을수록 좋다.

CCR1009-8G-1S-1S+ 라우터는 9코어의 타일레라 TileGX 프로세서, 2GB 메모리를 사용하며 기가비트 이더넷 8포트, 1G SFP 1포트, 10G SFP+ 1포트를 제공한다. 테스트 환경은 1G 인터페이스 8개에 클라이언트를, 10G 인터페이스에 서버를 연결해 접속수와 부하를 측정했다. 단순 라우트 모드에서 900초간 접속수는 277,012를 기록했으며, 포트당 최대 접속 수는 50,000을 넘겼고, 프로세서 부하는 6% 정도로 여유가 있다. 하지만 이더넷 포트 1, 2, 3번의 경우 최대 1000~1400 정도의 접속수만을 기록하는 모습을 보였다.

방화벽을 적용한 경우 900초간 접속 수는 309,521 정도로 집계되었으며, 이는 단순 라우트 모드보다도 오히려 많다. 하지만 이더넷 포트 1, 2, 3의 접속 수는 여전히 2,000~5,000 정도로 여타 포트의 60,000 정도에 비하면 크게 적은데, 이는 장비나 테스트 환경의 특성으로 보인다. 접속수는 전반적으로 시간에 따라 일정한 증가세를 유지했으며, 이더넷 포트 1~3번을 제외하면 포트별 연결분포도 일반 라우트 모드보다 더욱 일정한 모습이다. 프로세서 부하는 65% 정도로, 충분한 여유가 있다.

처리량 테스트에서는 단순 라우트 모드에서 클라이언트측 수신 3,405,175.36Kbps, 서버측 송신 3,376,044.13Kbps를 기록했으며, 프로세서 부하는 7% 수준이다. 방화벽이 적용된 경우의 성능은 클라이언트쪽 수신 3,065,701.43Kbps, 서버측 송신 3,077,276.61Kbps 정도로, 단순 라우트 모드와의 성능 차이도 적은 편이었으며, 프로세서 부하는 91%였다. RB850Gx2와 달리 접속 지연 추이도 수치 자체의 차이는 있지만 단순 라우트 모드와 방화벽 적용 모두 유사한 그래프를 보였다.

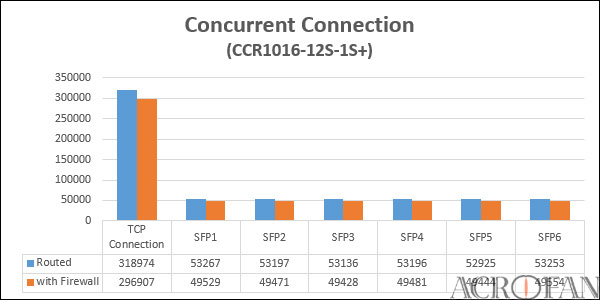

▲ CCR1016-12S-1S+ Concurrent Connection, 높을수록 좋다.

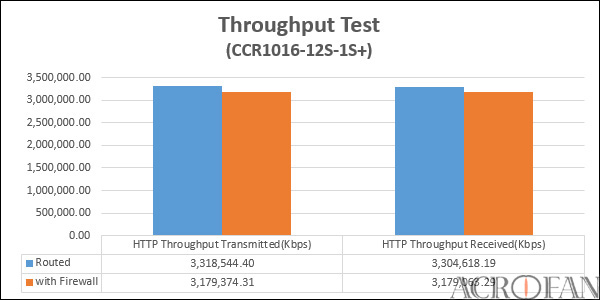

▲ CCR1016-12S-1S+ Throughput Test, 높을수록 좋다.

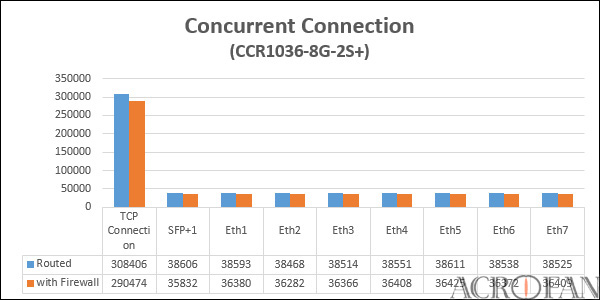

▲ CCR1036-8G-2S+ Concurrent Connection, 높을수록 좋다.

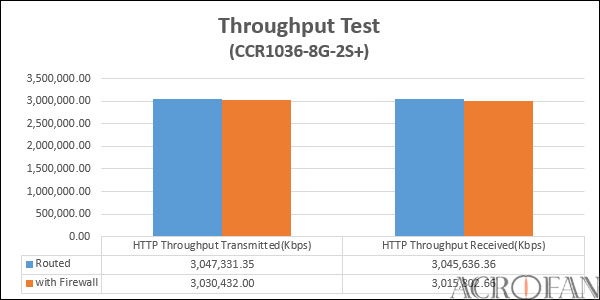

▲ CCR1036-8G-2S+ Throughput Test, 높을수록 좋다.

CCR1016-12S-1S+ 라우터는 16코어의 타일레라 TileGX 프로세서와 2GB DDR3 메모리를 사용하며, 12개의 1G SFP 포트와 1개의 10G SFP+ 포트를 제공한다. 테스트 환경은 총 각 1000개의 호스트로 구성되는 서브넷 6개가 1G 인터페이스를 통해 연결되고, 서버측은 10G 인터페이스 호스트 1개가 부여되었다. 이 때 단순 라우트 모드에서 900초간 최대 TCP 커넥션은 318,974개를 기록했으며, 방화벽이 적용된 경우 900초간 TCP 커넥션은 296,907개로 나타났고, 방화벽 사용시에도 프로세서 점유율은 26% 정도였다.

처리량 테스트에서는 단순 라우트 상황에서 클라이언트측 수신 3,304,618.19Kbps, 서버측 송신 3,318,544.40Kbps 정도로 측정되었으며, 방화벽이 적용되는 경우는 클라이언트측 수신 3,179,063.29Kbps, 서버측 송신 3,179,374.31Kbps 정도로 측정되었다. 방화벽 적용 유무에서 나타나는 성능 저하도 크지 않으며, 프로세서 부하는 방화벽을 적용시에도 27% 정도로 낮다. 접속 지연 또한 초기 반응이나 전체적인 그래프 추이에서 양 상황 모두 큰 차이가 없는 모습이다.

CCR1036-8G-2S+는 36코어의 TileGX 프로세서와 4GB DDR3 메모리를 사용하며, 8개의 기가비트 포트와 2개의 10G SFP+ 포트를 가지는 것이 특징이다. 테스트 구성은 10G 연결 서브넷 1개와 1G 연결 서브넷 7개로 총 8개의 서브넷이 1개의 10G 연결 호스트에 접속되며, 클라이언트의 각 서브넷은 1000개의 호스트를 가진다. 그리고 900초간의 최대 TCP 커넥션은 단순 라우트 모드에서 309,130개, 방화벽 적용시에는 291,299개를 기록했으며, 방화벽 적용시에도 프로세서 사용률은 3% 정도에 머물렀다.

처리량 테스트에서는 단순 라우트 상황에서 클라이언트측 수신 3,045,636.36Kbps, 서버측 송신 3,047,331.35Kbps로 측정되었으며, 방화벽 적용시에는 클라이언트측 수신 3,015,802.66Kbps, 서버측 송신 3,030,432.00Kbps 정도를 기록했다. 방화벽 적용 유무의 성능 차이는 테스트 환경에서 크게 차이나지 않으며, 장비 부하 또한 방화벽을 적용하더라도 4% 정도로, 내부 처리 성능에는 충분한 여유가 있음을 확인할 수 있으며, 이는 테스트 과정에서 초기 지연 시간이 크지 않은 데서도 나타난다.

Copyright ⓒ Acrofan All Right Reserved

- 2015-11-25 09:10 IT 소식 > 올드 PC, 이제는 스카이레이크 플랫폼으로 리프레시할 때

- 2015-11-25 09:04 IT 소식 > 오디오테크니카 헤드폰/이어폰/턴테이블 신제품 발표회 *1

- 2015-11-25 09:01 IT 소식 > 골드문트 나노 메티스 와이어리스 & 탈리스만 발표회

- 2015-11-06 09:56 게임 소식 > 플레이스테이션 VR 발표 SCEK 프레스 컨퍼런스

- 2015-11-02 09:46 IT 소식 > 왜 6세대 인텔 코어 프로세서를 선택해야 되는가? *1